转载:https://ai.zol.com.cn/896/8961276.html

2024-08-30 11:08:06·[??中关村在线 原创??]·作者:拿铁不加冰

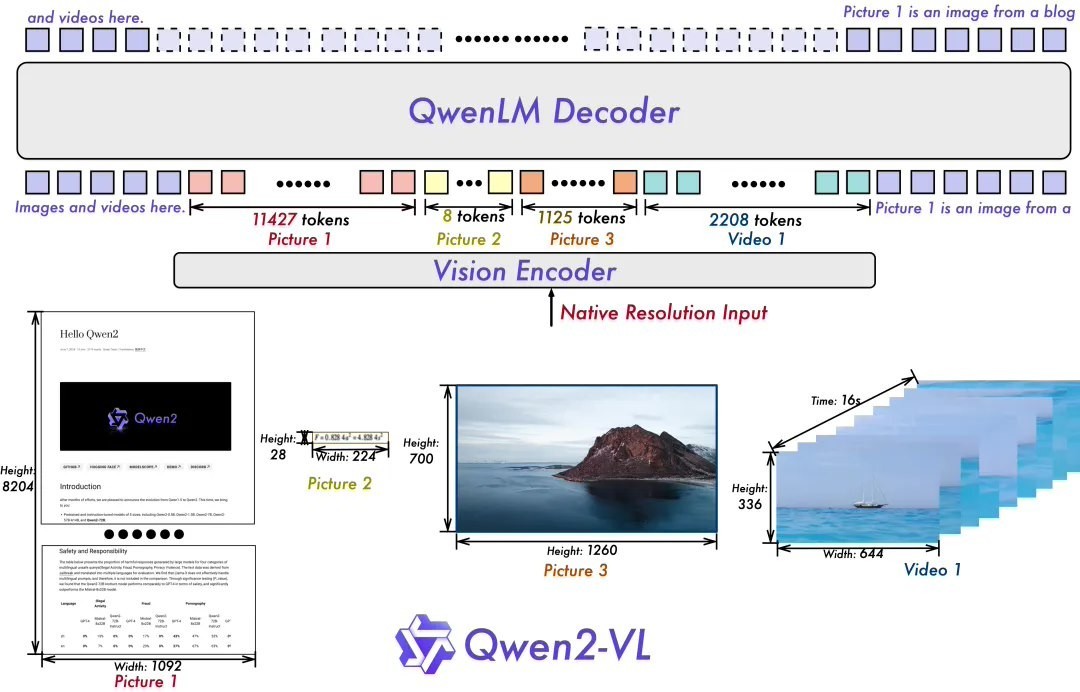

通义千问团队今天对 Qwen-VL(视觉语言、Vision Language)模型进行了更新,推出了新一代的Qwen2-VL。与之前的Qwen-VL相比,Qwen2-VL在架构上有了关键改进,实现了动态分辨率支持。这意味着该模型可以处理任意分辨率的图像而无需将其分割成块,并且能够确保输入与图像固有信息之间的一致性。这种方法更接近地模仿人类的视觉感知,从而使模型能够处理任何清晰度或大小的图像。

另一个重要的改进是引入了Multimodal Rotary Position Embedding(M-ROPE)。通过将original rotary embedding分解为时间、空间(高度和宽度)信息三个部分,M-ROPE使得Large Language Models能够同时捕获和集成1D文本、2D视觉和3D视频位置信息。这使大型语言模型不仅可以充当多模态处理器还可以用作推理器。

在7亿规模下,Qwen2-VL-7B保留了对图像、多个图像和视频输入的支持,并提供具有竞争力性能的成本效益较大的模型大小。

针对潜在移动设备部署需求优化设计的小型模型Qwen2-VL-2B,在参数量只有2亿时,在图像理解、视频理解和多语言理解方面都表现出色。

如果需要使用该模型,请参考链接如下:

Qwen2-VL-2B-Instruct:https://www.modelscope.cn/models/qwen/Qwen2-VL-2B-Instruct

Qwen2-VL-7B-Instruct:https://www.modelscope.cn/models/qwen/Qwen2-VL-7B-Instruct

本文属于原创文章,如若转载,请注明来源:阿里通义千问推Qwen2-VL:开源2B/7B模型,处理任意分辨率图像无需分割成块https://ai.zol.com.cn/896/8961276.html

当前位置:新闻详细

当前位置:新闻详细